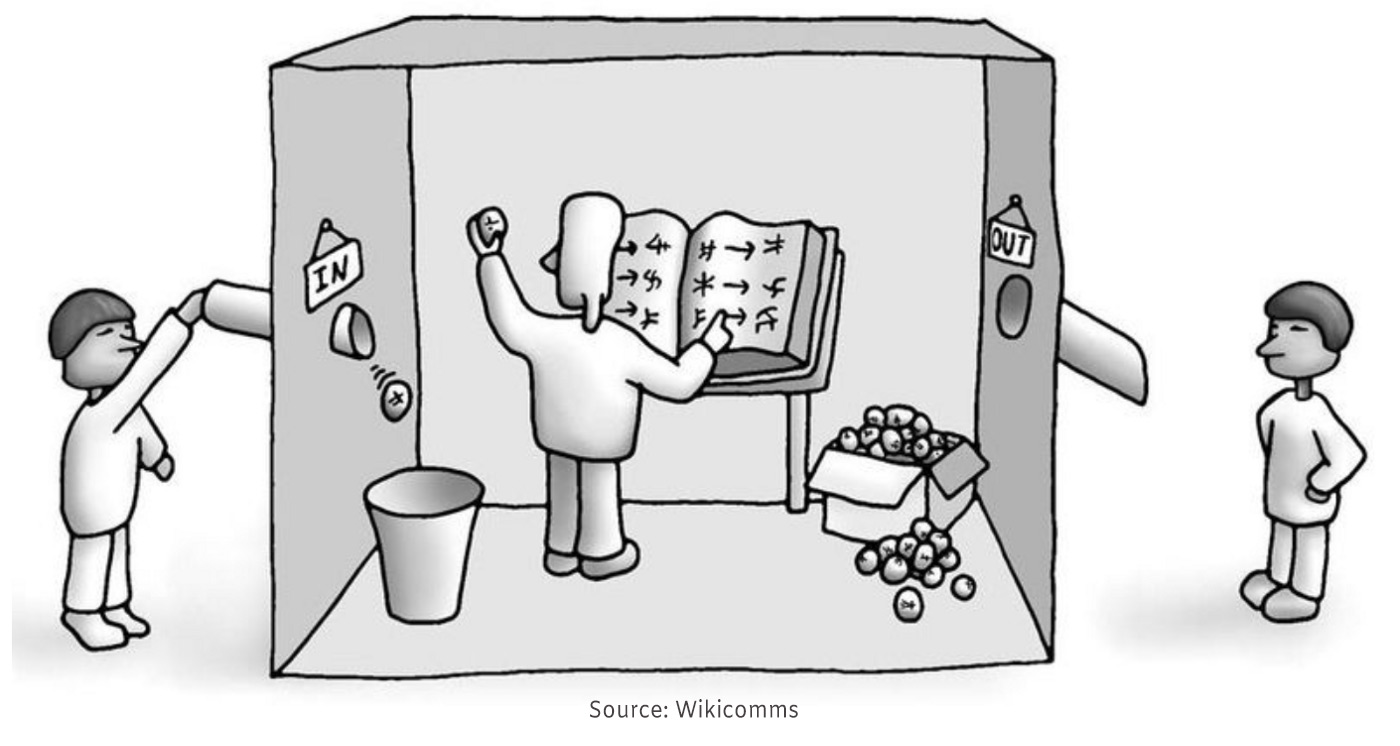

‘인공지능 윤리학’이라는 말은 사실 애매하다. 그것은 가령 인간이 인공지능을 어떻게 활용해야 하는지에 대한 도덕적 고찰을 의미할 수도 있고, 인공지능의 발전으로 인해 발생한 여러 곤란하고 낯선 상황들에 올바르게 대처하는 방식에 대한 연구를 의미할 수도 있다. 이 경우 인공지능 윤리학은 인공지능을 대상으로 확장된 공학윤리나 기술윤리가 될 공산이 크다. 그러나 인공지능과 도덕성이 가장 직접적으로 관련되는 것은, 바로 인공지능을 도덕적으로 만들 수 있는지, 아니 애당초 인공지능을 도덕적으로 만든다는 것이 무슨 뜻인지를 메타적으로 고찰할 때이다. 그런데 인공지능을 도덕적으로 만든다고 할 때, 인공지능만큼 중요한 개념이 바로 도덕성(morality)다. 인공지능의 도덕성을 운운할 때, 거기서 말해지는 도덕성은 하나의 통일된 개념으로 사용되고 있는 것일까? 여기서 요구되는 것은 기술윤리나 공학윤리보다는 도덕성에 대한 메타윤리적 고찰 또는 개념 분석이다. 두 가지 도덕성의 구별이 인공지능의 도덕성을 면밀하게 사고하는데 도움이 된다. 첫째는 기능적 도덕성(functional morality)이다. 기능적 도덕성이란 적어도 정상적이고 평균적이라 여겨지는 인간이 할 법한 도덕적 행위를 산출하는 것을 말한다. 어떤 상황에서 도덕적 행위를 한다고 할 때, 인공지능이 동일한 상황에서 인간이 수행하는 것과 유사한 행위를 할 때 그 인공지능은 기능적으로 도덕적이라고 할 수 있는 것이다. 여기서 인공지능이 어떻게 그런 도덕적 행위를 산출했는지는 고려사항이 아니다. 동일한 상황에서 얼마나 인간과 유사한 행위를 했는지, 즉 동일한 입력에 대해서 유사한 출력을 내놓는지가 핵심인 것이다. 이처럼 기능적 도덕성에서는 초점이 기능에 있지, 도덕성에 있지 않다. 엄밀히 말해 기능적 도덕성의 인공적 구현은 인간의 도덕적 행위에 대한 모사(simulation)의 성공 여부에 달려있다. 모사되어야 행위가 도덕적인 종류일 따름이다. 사실상 인공도덕행위자(artificial moral agent, AMA)를 체계적으로 분류한 무어(James H. Moore)가 말하는 도덕성, 그리고 무어의 분류만큼 널리 쓰이는 월러치와 알렌(Wendell Wallach and Colin Allen)의 분류에서 기준이 되는 도덕성 또한 기능적 도덕성이라고 보아야 한다. ‘기능적 도덕성’이라는 용어를 최초로 사용한 것도 월러치와 알렌이다. 기능적 도덕성에는 다양한 수준과 정도가 있을 것이다. 동일한 입력에 대해 인간의 도덕적 행위와는 다른 엉뚱한 행위를 할 경우 기능적 도덕성의 수준은 떨어질 것이고, 반대로 도덕적 행위에 있어서 인간과 거의 구분이 되지 않는다면 인간과 동일한 수준의 기능적 도덕성을 가질 것이다. 이처럼 기능적 도덕성이 궁극적으로 인간과의 기능적 유사성을 통해서 결정된다면, 이 유사성은 일종의 도덕 튜링 테스트(moral Turing test)를 통해 측정될 수 있을 것이다. 도덕 튜링 테스트는 튜링 테스트를 도덕적 상황에 특화시킨 것으로, 현재 실제로 개발이 시도되고 있는 도덕성 측정 기구다. 도덕 튜링 테스트에서 높은 점수를 받을 수록 기능적 도덕성의 수준 또한 높을 것이다. 가령 10세 아동의 도덕 수준에 맞추어진 도덕 튜링 테스트를 개발하고, 인공지능이 그 테스트를 통과한다면, 그 인공지능은 적어도 10세 아동 수준의 기능적 도덕성을 가진다고 할 수 있다. 반면에, 내재적 도덕성(intrinsic morality)이라고 할 만한 도덕성도 존재한다. 내재적 도덕성은 인간이 할 법한 행위를 산출할 뿐 아니라, 실제로 인간과 같은 방식으로 그렇게 하는 것을 말한다. 즉 내재적 도덕성은 기능적 도덕성을 함축하는 것이다. 일견 인간이 할 법한 도덕적 행위를 하면 당연히 인간과 같은 방식으로 그렇게 한다고 볼 수 있을 것 같지만, 사실은 그렇지 않다. 기능적 도덕성에서는 어떻게 인간이 그런 도덕적 행위를 산출하는지에 대한 고려가 완전히 빠져있으며, 오직 같은 상황에서 같은 행위를 하는 것만이 문제가 된다. 그러나 내재적 도덕성은 바로 그런 ‘어떻게’를 필수적으로 요구한다. 가령 인간은 여러 ‘도덕 관념’을 이해하고, ‘도덕 원칙들’의 의미를 알며, 그것을 따라야 한다는 ‘규범성’을 인식한다. ‘반성’ 또는 ‘성찰’을 통해서, ‘다른 식으로 판단하고 행위할 수 있음’에도 불구하고, 해야 하는 바를 선택하고 실천하려고 한다. 인간은 이런 과정들을 통해 도덕적 행위를 산출하며, 따라서 인공지능 또한 이런 과정들을 가질 때 기능적으로는 물론 내재적으로도 도덕적일 수 있다. 내재적 도덕성을 인공적 구현을 위해서는 따옴표로 강조된 것들, 즉 도덕 원칙, 규범성, 반성과 성찰, 자유 의지 등의 일부를 구현할 수 있어야 할 것이다. 기능적 도덕성과 내재적 도덕성의 구별은 소위 약한 인공지능(weak AI)과 강한 인공지능(strong AI)의 구별에 대응한다고 할 수 있다. 주지하다시피, 철학자 존 설(John Searle)은 중국어 방(Chinese room) 사고 실험을 통해 만약 인공지능이 이상적 튜링 테스트를 통과한다면 인간과 마찬가지의 사고를 한다고 볼 수 있다는 강한 인공지능론자들의 주장을 비판한 바 있다. 이런 사례를 참조해서, 우리는 도덕적 중국어방(moral Chinese room)을 상상해 볼 수 있을 것이다. 즉 방 바깥에서 입출력만 보면 정상적이고 평균적인 인간과 완전히 동일한 도덕적 판단과 행위를 하지만, 실제로는 어떤 도덕 원칙이나 규범성에 대한 직관, 성찰, 자유의지도 없는 반사회적 성격장애자 한니발이 방에 갇힌 채 도덕적 행위에 대한 방대한 매뉴얼을 기계적으로 따르고 있을 뿐인 상황을 상상해볼 수 있는 것이다. 방 안에 갇힌 한니발이 정상적인 인간과 같은 방식으로 도덕적이지는 않다는 것은 명백하다. 그렇다면 그 ‘한니발+방’으로 구성된 방 전체, 즉 ‘한니발의 방’은 인간과 같은 방식으로 도덕적이라고, 즉 내재적으로 도덕적이라고 해야 할까? 만약 한니발의 방이 내재적 도덕성을 가진다면, 어떤 잘못된 행위가 일어났을 때 그것을 도덕적으로 비난하면서 그에 대한 책임을 물을 수 있을까? 이 질문들에 ‘예’라고 답한다면, 기능적 도덕성이 곧 내재적 도덕성을 함축한다는 것을 인정하는 셈이고, 따라서 기능적 도덕성을 구현하는 AMA, 말하자면 약한 AMA(weak AMA)가 곧 인간과 동일한 도덕적 행위자라고, 즉 강한 AMA(strong AMA)라고 인정해야 할 것이다. 당신은 어떻게 생각하는가? 문규민 (중앙대학교 인문콘텐츠연구소 HK연구교수) |