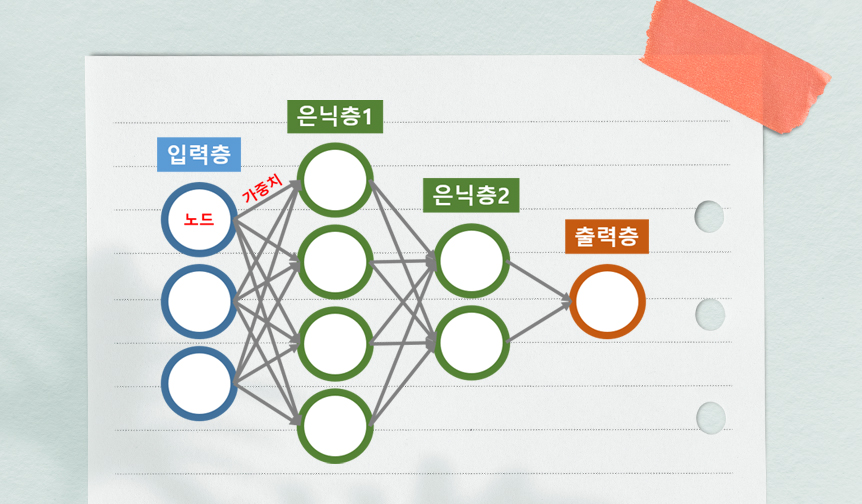

심층신경망 내 노드, 엣지(가중치) 모습. 학습 데이터 입력 시 목표값에 맞춰 가중치값이 계속 수정되는 방식이다. 많은 데이터를 학습하면 그만큼 많은 경우의 수를 반영하게 된다.

“화자(話者)가 누구인가?”가 중요해진 세상

심층학습(deep learning) 기반 언어모델(language model)이 조만간 우리의 일상을 바꿔 놓을 전망이다. 언어모델이란 단어의 배열에 확률을 할당하여 자연스러운 단어의 배열을 유추하는 모델로, 질의응답, 기계번역, 문서요약, 텍스트 분류 등에 활용될 수 있으며, 근본적으로는 특정 단어들이 주어졌을 때 다음에 올 단어를 예측한다든지, 주어진 양쪽의 단어들로부터 가운데에 위치할 단어를 예측하는 등의 작업을 수행할 수 있다.

작년에 OpenAI가 발표한 GPT-3라는 거대 언어모델이 놀라운 영어 문장 생성 능력으로 화제가 되었는데, 올들어 네이버도 HyperCLOVA라는 초대형 한국어 언어모델을 공개해 상업화에 뛰어 들었고, 구글도 조 단위의 파라미터를 갖는 Switch Transformer라는 언어모델과, 오픈도메인(즉, 특정 주제에 국한되지 않는) 대화형 시스템을 위한 LaMDA(Language Model for Dialogue Applications: 람다)라는 언어모델을 공개해 다양한 상업적 활용을 꾀하고 있다.

언어모델은 인공지능(AI) 시스템이 사람과 자연스러운 의사소통을 하는데 도움을 주는 기술이다. “자연스러운 의사소통”이 어떤 것인가에 대한 정의는 다양하겠지만, 가장 기초적인 부분에 초점을 맞춘다면 문장을 자연스럽게 완성하는 기술이라 말할 수 있다. 가령 필자가 지금 이 글을 읽고 있는 독자에게 “나는 연필로 편지를 ____.”라는 문장을 완성해달라고 요청하면, 많은 분들이 “쓴다/썼다”로 빈 칸을 채울 것이다. 언어모델의 경우에는 제시된 문장을 “나/는/연필/로/편지/를” 등의 문자열 단위로 쪼개, 이들의 배열을 고려하여 수 만 개의 단어들 중 문장 끝에 올 확률이 가장 높은 단어를 선택하는 것으로 문장을 완성한다. 그리고 어마어마한 양의 우리말 말뭉치를 잘 학습한 고성능 언어모델이라면 사람처럼 “쓴다/썼다”로 문장 끝 빈 칸을 채울 것이다.

이처럼 쓸모가 많은 언어모델은 그 규모가 클수록 더 높은 성능을 가지는 것으로 확인되고 있다. ‘초대형’, ‘대규모’, ‘초거대’라는 수식어에서 알 수 있듯이 최근의 언어모델 연구개발 트렌드는 “더 크게! 더 크게!”를 지향한다. 여기서 말하는 언어모델의 크기는 언어모델을 구성하는 인공신경망의 가중치(흔히 파라미터라고 부른다)의 개수를 가리키며, OpenAI의 GPT-3는 1,750억 개의 파라미터를, 네이버의 HyperCLOVA는 이보다 많은 2,040억 개의 파라미터를, 그리고 구글의 Switch Transformer는 1.7조 개의 파라미터를 가진다. 파라미터의 개수가 천 억 단위, 조 단위라는 것이 막연하게 느껴질 수 있지만, 개수를 화폐 단위인 원으로 바꿔 생각하면 조금 더 실감이 난다.

이러한 언어모델은 방대한 양의 말뭉치를 이용하여 가중치를 갱신하는 방법으로 만들어 지는데, 말뭉치의 문장들을 뒤섞은 후 언어모델로 하여금 문장을 하나씩 ‘읽게’ 하여 언어모델이 문장의 구성을 ‘파악’하게 한 다음 가중치를 경신하게 하고, 한 번에 딱 맞는 가중치를 찾기는 어렵기 때문에, 읽고, 파악하고, 가중치를 경신하는 작업을 무수히 반복하게 한다. 결국 언어모델은 여러 차례 말뭉치 속 문장들을 ‘참조’하면서 말뭉치의 ‘말투’를 잘 흉내 내는 방향으로 가중치를 수정함으로써 궁극적으로는 사람과 비슷한 문장 완성 능력을 습득하게 된다. 언어모델이 엄청난 양의 문장을 파악하기 위해 오랜 시간 동안 수 천 억 개, 수 조 개의 소수점 값을 반복적으로 경신하는 모습을 그리자니 그 까마득함에 정신이 아득해진다. 이렇게 구축된 언어모델은 언어에 대한 지식을 내재하고 있어 언어를 이용한 작업의 자동화에 도움을 준다.

필자는 요즘 동료 연구자와 함께 다양한 한국어 딥러닝 언어모델을 활용한 혐오 발언 자동 분류 연구를 진행하고 있는데, 이 연구에서는 위키피디아를 주로 학습한 KoBERT라는 한국어 딥러닝 언어모델과, 뉴스 댓글을 학습한 KcELECTRA라는 또 다른 한국어 딥러닝 언어모델을 사용하고 있다. 그런데 혐오 발언 분류 실험에서는 KcELECTRA가 조금 더 높은 분류 정확도를 나타내, 댓글로 학습한 언어모델이 위키피디아로 학습한 언어모델 보다 혐오 발언 검출에 더 적합하다는 사실을 확인할 수 있었다.

결국 딥러닝 언어모델은 사람의 말투를 흉내 내는 기술로, 학습 대상 말뭉치에 따라 결과 모델이 달라질 수 있다. 그렇기 때문에 언어모델은 질의 응답 등의 유용한 활용도 많겠지만 악용될 소지도 있을 것이다. 가령 우리나라의 대표적인 N포털과 D포털에서 뉴스 댓글을 수집한 후 언어모델N과 언어모델D를 구축하고, 어떤 의도에 따라 특정 언어모델을 선택한 후 댓글 생성기를 만들어 마구잡이로 댓글을 유통시킨다면 어떻게 될까? 이처럼 언어모델을 통해 대량의 텍스트를 손쉽게 양산할 수 있는 시대가 되면서 글쓴이가 누구인지를 각별히 신경 써야 하는 세상이 되었다. 의견의 홍수 속에서 “화자(話者)는 누구인가?”를 의식하는 습관이 그 어느 때보다도 필요한 시점이다.

조희련 (중앙대학교 인문콘텐츠연구소 HK교수)

AI 타임즈 링크 http://www.aitimes.com/news/articleView.html?idxno=139957

|